Управление LLM (UI & API)

После запуска платформы Compressa, все компоненты будут доступны по одному и тому же URL (8080 по умолчанию)

Управление платформой обеспечивается через API диспетчера (добавление моделей, деплой моделей, тесты).

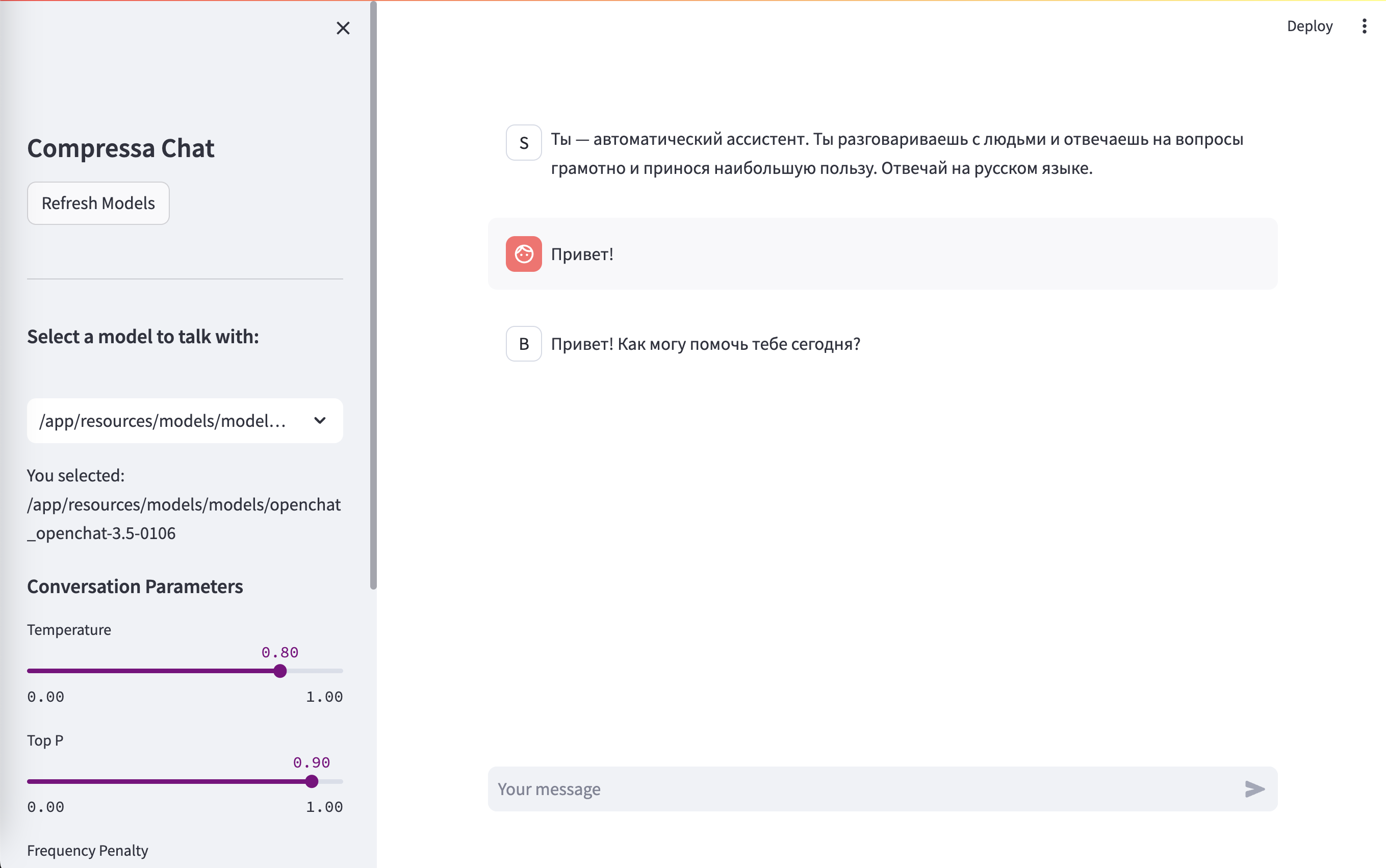

Chat UI

URL: http://localhost:8080/chat/

UI Playground для тестирования разных настроек LLM и подбора промптов.

Fine-tuning

Вы можете дообучать модели с помощью LoRA/QLoRA как с помощью UI интерфейса, так и с помощью REST API. Кроме этого, доступен UI дэшборд для мониторинга процесса дообучения и метрик

Подробнее о процессе дообучения моделей на специальной странице.

Дообучение проводится вне платформы (в режиме Single-Pod)